relu函数权威发布_relu函数比sigmoid函数的优势(2024年12月精准访谈)

神经网络的秘密武器:激活函数详解 嘿,小小科学家们!今天我们来聊聊人工神经网络中的一个超级重要的角色——激活函数。你可能好奇,什么是激活函数呢?别急,我们慢慢揭开它的面纱。ˆ ” 什么是激活函数? 想象一下,如果我们的大脑只是简单地把信息从一个地方传递到另一个地方,那我们能做的事情就很有限了。激活函数在人工神经网络中就像是一个“大脑的开关”,它决定信息是被传递还是被忽略,而且还能增加网络的非线性能力,让网络能够学习和处理更复杂的任务。 š 激活函数的作用 激活函数的主要作用有两个: 引入非线性:让神经网络能够学习和模拟复杂的输入输出关系。 决定信息流:控制信息在神经网络中的流动。 常见的激活函数 Sigmoid函数:它的形状像一个“S”,可以把输入值压缩到0和1之间。它在二分类问题中特别有用。 Tanh函数:这是Sigmoid函数的变种,输出值在-1和1之间,常用于输出值需要中心化的情况。 ReLU函数:全名是“Rectified Linear Unit”,它在正数部分的斜率是0,在负数部分的斜率是1。它计算简单,训练速度快,是目前最流行的激活函数之一。 Leaky ReLU:这是ReLU的改进版,它允许负数有一个小的非零斜率,可以解决ReLU的死亡ReLU问题。 Softmax函数:通常用于神经网络的最后一层,特别是多分类问题中,它可以输出一个概率分布。 ˆ 激活函数的重要性 激活函数是神经网络中不可或缺的一部分。没有它们,我们的神经网络就只是一堆线性方程,无法处理复杂的任务。 € 结语 激活函数就像是神经网络的调味品,给网络增添了“味道”,让它更加强大和灵活。下次你听到人工智能的时候,不妨想想这些默默工作的激活函数,它们可是背后的英雄哦! 如果你对激活函数或者人工智能有更多的好奇,记得留言,我们一起探索更多的奥秘!

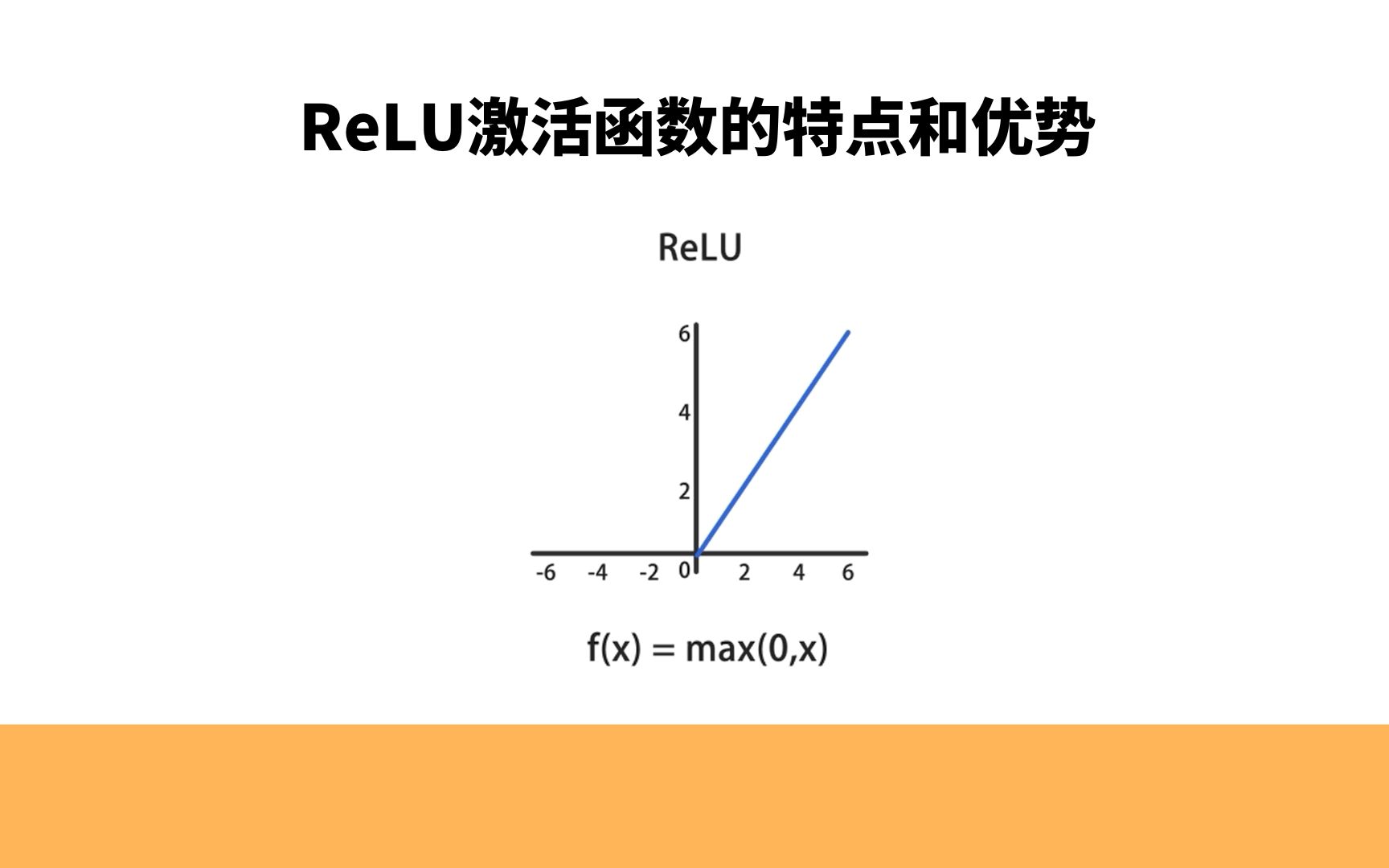

常见激活函数及其特点详解 在神经网络中,选择合适的激活函数至关重要。以下是几种常见的激活函数及其特点: Sigmoid激活函数 ˆ 范围: (0, 1) 优点:输出范围有限,适用于二分类问题或输出概率。 缺点:在深度网络中,容易出现梯度消失问题,不推荐在隐藏层中使用。 Hyperbolic Tangent (tanh)激活函数 € 范围: (-1, 1) 优点:相对于Sigmoid,均值接近零,减轻了梯度消失问题。 缺点:仍然可能存在梯度消失问题,不太适用于深度网络。 Rectified Linear Unit (ReLU)激活函数 ኦ(x) = max(0, x) 优点:在训练中收敛速度较快,计算简单,适用于大多数情况。 缺点:可能导致神经元死亡问题(某些神经元永远不会激活),对梯度下降要求谨慎初始化权重。 Leaky ReLU激活函数 犦(x) = max(ax, x)(通常a是一个小的正数,如0.01) 优点:在x < 0时有小的斜率,避免了死亡神经元问题。 缺点:在某些情况下,可能导致激活值过小,不适用于所有问题。 Parametric ReLU (PReLU)激活函数 犦(x) = max(ax, x)(其中a是可学习的参数) 优点:类似于Leaky ReLU,但a可以通过训练来学习。 缺点:在小数据集上可能过拟合。 Scaled Exponential Linear Unit (SELU)激活函数 ‡ꥸ楽’一化效果,有助于减轻梯度消失和爆炸问题。适用于某些情况,但不是所有。 Softmax激活函数 … 用于多类别分类问题,在输出层将原始分数转换为概率分布。 范围: (0, 1),且所有输出的和为1。 前向传播 前向传播是神经网络中的一个步骤,是神经网络推断(inference)的过程,用于将输入数据通过网络的各层,最终产生输出。在这个过程中,输入数据通过网络的输入层(第一层),经过每一层的权重和激活函数,逐步传播(经由隐藏层)到输出层。每个神经元都接收来自上一层的输入,并生成一个输出,然后将其传递给下一层。这样的传播过程一直持续到达输出层,最终得到神经网络的预测结果。前向传播是计算损失(预测值与实际值之间的差异)的一部分,以便通过反向传播来调整权重,从改进网络的性能。

€优化神经网络:加速与精度提升ŸŽŒ–神经网络是提升训练速度和准确度的关键。让我们来探讨一些关键策略: 1️⃣ 高效数据输入: - 利用SSD、缓冲池等优化I/O传输,确保数据输入的高效。 - 将数据读入、处理与模型计算并行进行,最大化硬件效率。 2️⃣ 增大batch size: - 增大batch size可利用更多计算资源,从而加快训练速度。 - 但要注意,过大的batch size可能导致精度损失,因此需找到合适平衡。 3️⃣ 防止过拟合: - 添加Batch normalization层,规范特征分布,使输出更均匀。 - 对参数进行正则化,如weight、bias等,以减少过拟合风险。 - 使用dropout技术,阻碍网络学习局部“额外规律”,增强泛化能力。 4️⃣ 引入Inception结构: - 通过嵌入多尺度信息,聚合不同感受野上的特征,提升模型性能。 5️⃣ 优化权重初始化: - 合理的权重初始化可以减少训练耗时,提高训练稳定性。 - 避免“dying ReLU”等问题,使用leaky relu函数等进行优化。 ᠩ€š过这些策略的综合应用,你可以有效优化神经网络,实现训练速度与准确度的双重提升!€

如何搭建一个神经网络 想要搭建一个简单的神经网络?用PyTorch来搞定吧!神经网络的基本组成单位是层(Layers),通常由多个层叠加而成。PyTorch的torch.nn库里有很多常见的层类型,比如全连接层可以用nn.Linear来实现,卷积层则可以用nn.Conv2d来实现。 首先,你需要定义一个类来构建你的神经网络,这个类需要继承PyTorch的nn.Module基类。定义神经网络的步骤主要有两部分: 在__init__函数中定义网络结构和层 在forward函数中定义数据通过网络的方式 下面是一个简单的神经网络示例代码,它定义了一个两层全连接网络(Fully-Connected Networks, FC): 输入数据首先通过fc1层:x = self.fc1(x) 然后应用ReLU激活函数:x = torch.relu(self.fc1(x)) 接着通过fc2层:x = self.fc2(x) 最后输出结果:return x 在实际操作中,还需要用到代价函数、训练数据和优化器等工具,才能达到你想要的效果。 希望这个简单的示例能帮你入门神经网络的搭建!€

投资理财书单(三)《机器学习与股票择时》邱月 著 随着计算机技术在运算能力、数据存储等方面的快速发展,传统股票投资方法的弊端被不断放大,新兴的量化投资方法受到人们的广泛关注,依赖计算机技术的机器学习算法越来越多的应用在股票研究领域之中。支持向量机、K紧邻、遗传算法等多种机器学习算法都被成功应用于量化投资领域,本书改进了FA算法的动态搜索能力,将MFA算法应用于变量的选取及参数寻优,系统地构建了基于MFA-SVM的量化择时模型;针对传统神经网络层数不足等局限性,提出一种适用于股票择时问题的混合CNN-RNN模型,由一维CNN模块(卷积层和池化层)、RNN模块(双层LSTM和双层GRU)、ReLU激活函数层组成,并进行了实证研究,为相关学者后续研究提供了新思路和新方法。本书可供信息管理与金融类专业高年级本科生与研究生使用,也可供从事机器学习技术与应用研究的科研人员、金融市场数据分析人员以及机器学习软件开发人员参考。

神经网络权重初始化指南:选择最佳策略 在训练神经网络时,权重初始化的选择至关重要。不同的初始化方法会对网络的训练过程和性能产生深远影响。以下是一些常见的权重初始化策略及其优缺点: 零初始化 将所有权重初始化为0是最简单的方法。然而,这种方法会导致所有神经元在训练初期具有相同的输出,进而在反向传播过程中进行相同的更新,这可能不利于网络的训练。 随机初始化 𒊩š机初始化是一种常见的选择,权重可以从均匀分布或正态分布中随机抽取。这种方法可以打破权重的对称性,但初始值的选择不当可能会导致训练的不稳定性。 Xavier/Glorot初始化 銨🙧獦–•专为Sigmoid和Hyperbolic Tanh激活函数设计,公式如下: w=random_number√ninputsw = \frac{\text{random_number}}{\sqrt{n_{\text{inputs}}}}w=random_numberninputs 这种方法有助于保持权重在初始化时的分布,有助于网络的稳定训练。 He初始化 𐊤eLU激活函数设计的初始化方法,公式为: w=random_number㗲ninputs−−−−−−√w = \text{random_number} \times \sqrt{\frac{2}{n_{\text{inputs}}}}w=random_number㗮inputs2 这种方法考虑了ReLU激活函数的特性,有助于加速网络的训练。 LeCun初始化 ኩ’ˆ对Sigmoid激活函数的初始化方法,公式为: w=random_number㗱ninputs−−−−−−√w = \text{random_number} \times \sqrt{\frac{1}{n_{\text{inputs}}}}w=random_number㗮inputs1 这种方法有助于保持权重在初始化时的分布,有助于网络的稳定训练。 正交初始化 Ÿ♂️ 在这种方法中,权重矩阵的行都是正交的,这在某些深度学习应用中是有益的,尤其是在循环神经网络中。这种方法可以确保网络在初始化时具有更好的结构性质。 正确的权重初始化可以加速训练的收敛,并降低训练过程中的不稳定性。选择合适的初始化策略可以大大提高神经网络训练的速度和稳定性。

5种常见激活函数优缺点对比 激活函数在神经网络中扮演着至关重要的角色,它们为网络引入了非线性,使得网络能够更好地逼近复杂的函数。接下来,我们来探讨5种常见的激活函数及其优缺点。 igmoid函数 优点: Sigmoid函数的输出范围在[0, 1]之间,输出可以看作概率值。 在输出接近0或1时,梯度较大,有助于梯度下降。 缺点: Sigmoid函数的梯度在中心附近接近0,导致梯度消失的问题。 Sigmoid函数的指数运算相对较慢,计算效率较低。 anh函数 优点: Tanh函数的输出范围在[-1, 1],对于一些以0为中心的数据集具有更好的表示能力。 Tanh函数相对于Sigmoid函数会压缩数据,使得训练更加稳定。 缺点: Tanh函数也存在梯度消失的问题。 Tanh函数的计算效率较低。 eLU函数 优点: ReLU函数在正区间上是线性的,计算速度非常快。 ReLU函数解决了梯度消失的问题,并且在训练中表现更好。 缺点: ReLU函数的负区间输出为0,可能导致神经元死亡。 ReLU函数不是严格可微的,在0点处的导数为0。 eaky ReLU函数 优点: Leaky ReLU函数在负区间上引入了一个小的负斜率,以避免神经元死亡问题。 Leaky ReLU函数计算速度快,相较于其他函数具有更好的训练性能。 缺点: Leaky ReLU函数引入了一个额外的超参数,需要手动选择合适的负斜率。 LU函数(Exponential Linear Unit) 优点: ELU函数在负区间上引入了指数形状,相较于Leaky ReLU函数更加平滑。 ELU函数解决了ReLU函数中的神经元死亡问题,并且在训练中表现更好。 缺点: ELU函数的计算速度较慢,相较于ReLU函数需要更多的计算资源。 在实践中,ReLU及其变种(如Leaky ReLU、ELU)常常被使用,由于其较好的训练性能和计算效率。然而,对于输出是概率的问题,如二分类问题,Sigmoid函数是一个常见的选择。最佳的选择取决于具体任务和网络结构,我们要根据实验和验证来确定最适合的激活函数。希望以上的分享对你有帮助!

深度学习函数详解:从基础到优化 ˆ 深度学习函数是神经网络的核心,它们决定了模型的性能和功能。以下是深度学习函数的一个全面总结: 一、激活函数 ReLU(Rectified Linear Unit):将大于0的数原数输出,小于或等于0的数输出0。ReLU具有稀疏性,计算复杂度低,但存在输出不是0对称和梯度消失的问题。 Sigmoid:将任意实数值压缩到(0,1)区间内,适用于二分类问题的输出层。但Sigmoid函数存在梯度消失和计算量大的缺点。 Tanh:将任意实数值压缩到(-1,1)区间内,解决了Sigmoid函数输出不是0对称的问题,但同样存在梯度消失和计算量大的问题。 Softmax:将多分类的输出转换为概率分布,确保输出值的范围在[0,1]之间,并且所有输出的总和为1。Softmax函数在多分类问题中广泛应用。 二、损失函数 ‰ 均方误差(Mean Squared Error, MSE):用于回归任务,计算预测值与真实值之间差的平方的平均值。 交叉熵(Cross-Entropy):用于分类任务,特别是多分类任务。交叉熵损失函数能够很好地衡量模型预测的概率分布与真实概率分布之间的差异。 三、优化函数 € 梯度下降(Gradient Descent):最常用的优化算法之一,通过计算损失函数关于模型参数的梯度,并沿着梯度的反方向更新参数。 Adam:一种基于自适应估计的一阶优化算法,能够自动调整学习率,适用于大多数深度学习模型。 Adagrad、RMSProp等:其他常见的优化算法,各有特点,适用于不同的场景和需求。 四、其他函数 ️ 卷积函数:在卷积神经网络(CNN)中广泛使用,用于提取图像等数据的局部特征。 池化函数:用于降低数据的空间维度,减少计算量和参数数量,同时保留重要特征。常见的池化操作包括最大值池化和均值池化。 数据预处理函数:如数据标准化、归一化等,用于改善模型的收敛速度和性能。 五、函数的作用与影响 Ÿ 激活函数:引入非线性因素,使神经网络能够学习复杂的数据表示和特征。 损失函数:指导模型优化方向,衡量模型性能的好坏。 优化函数:调整模型参数以最小化损失函数,提高模型的预测准确性。

秋招机器学习必备:这些知识点你掌握了吗? ReLU激活函数 eLU(Rectified Linear Unit)的公式是f(x)=max(0,x)f(x) = max(0, x)f(x)=max(0,x)。它在0的位置是不可导的,但这并不影响它的使用效果。 神经网络的正则化操作 神经网络中常见的正则化操作有L1正则化、L2正则化、dropout等。Dropout作为一种正则化方法,可以有效地防止过拟合。 1*1卷积核的作用 1*1卷积核主要用于调整通道数,不改变空间尺寸。它在一些网络结构中起到关键作用,比如Inception系列。 LSTM的结构 ‹️♂️ LSTM(Long Short-Term Memory)是一种特殊的RNN(循环神经网络),它通过门控机制来记忆长期依赖信息。LSTM在自然语言处理、时间序列预测等领域有广泛应用。 随机森林与GBDT的区别 𓊩š机森林和GBDT(梯度提升决策树)都是集成学习的方法,但它们有不同的构建方式和目标。随机森林通过随机选择特征来构建多个决策树,而GBDT则是通过梯度下降优化目标函数来构建决策树。 特征处理策略 ️ 特征处理是机器学习中非常重要的一步。常见的特征处理策略包括缺失值处理、连续值处理和分类值处理。比如,对于缺失值,可以通过均值、中位数或众数进行填充;对于连续值,可以进行标准化或归一化处理;对于分类值,可以使用one-hot编码。 One-hot编码的作用 One-hot编码是一种将分类变量转换为机器学习模型可以处理的格式的方法。它通过为每个类别创建一个二进制向量来表示分类值。 特征归一化的意义 ⚖️ 特征归一化是将不同量纲的特征转换为同一量纲的过程,这样可以避免模型对某个特征过分关注,从而提高模型的泛化能力。 交叉验证的重要性 „ 交叉验证是一种评估模型性能的方法,它将数据集分为训练集和测试集,然后重复多次训练和测试过程。通过交叉验证,可以更准确地评估模型的性能和泛化能力。 梯度消失和梯度爆炸 劦⯥䱥’Œ梯度爆炸是深度学习中常见的两个问题。梯度消失指的是在反向传播过程中,梯度逐渐减小到接近零,导致模型无法更新;梯度爆炸则是指梯度过大,可能会破坏模型的稳定性。 如何缓解梯度消失和梯度爆炸 缓解梯度消失和梯度爆炸的方法有很多,比如使用合适的激活函数(如ReLU)、初始化权重、调整学习率等。此外,一些优化算法如Adam也可以有效缓解这些问题。 生成模型与判别模型的区别 튧”Ÿ成模型和判别模型是两种不同的机器学习方法。生成模型学习数据的分布,生成新的数据样本;而判别模型则学习数据的分类边界,对数据进行分类或回归。 决策树处理连续值的方法 𓊥†–树在处理连续值特征时,通常会将连续值离散化或进行分段处理,然后为每个分段创建一个新的特征。这样可以避免连续值对模型的影响过大。 希望这些知识点能帮助你在秋招中更好地应对机器学习相关的问题!ꀀ

KAN能否成为神经网络新范式? š 多层感知器(MLP)的传统范式 要理解KAN的意义,首先得回顾一下神经网络的传统范式——多层感知器(MLP)。MLP通过分层处理来构建计算模型,基本结构包括激活函数(如ReLU或sigmoid)、可调权重(W)、偏置(B)和输入(x)。在MLP中,通过将输入与权重相乘、添加偏置并应用激活函数来处理输入数据。训练MLP的核心在于优化权重(W)组合,以提升特定任务的性能。MLP的数学基础源自Tsybenko定理,表明前馈神经网络能够逼近任何连续函数。然而,该定理并未指导如何选择网络参数以实现目标函数。 𑠋AN:新的神经网络架构 Kolmogorov-Arnold Network(KAN)则不同于传统的MLP,它受到Kolmogorov-Arnold表示定理的启发。KAN用可学习的函数代替固定的激活函数,并消除了对线性权重矩阵的需求。KAN中的激活函数位于边缘而非节点,允许权重参数由单变量函数(如样条)替代,使得网络在建模复杂函数时更具灵活性和可解释性。 – Kolmogorov-Arnold定理 Kolmogorov-Arnold定理由数学家Kolmogorov和Arnold提出,证明了多变量函数可以表示为有限数量的双变量函数的组合。这一理论为KAN的构建提供了数学基础,解决了高维函数逼近中的挑战。通过优化这些一维函数,KAN能减少复杂性和参数数量。 KAN与MLP的比较 KAN利用样条曲线代替MLP中的线性权重,这种设计使KAN能够以更少的参数和增强的可解释性建模复杂函数。KAN通过优化样条函数的参数来调整函数形状,显著降低了建模的复杂性。 „ KAN的优缺点 KAN的优点包括: 边缘激活:激活函数在网络边缘而非节点应用,提升了学习的灵活性和可解释性。 模块非线性化:在输入求和之前应用非线性函数,允许更精确地控制输入对输出的影响。 然而,KAN也面临挑战: 复杂性和过拟合:在数据有限时可能出现过拟合,复杂模型可能捕获噪声作为重要模式。 计算效率:KAN可能面临GPU优化问题,导致计算速度较慢,需探索适用于KAN的计算平台。 † 结论 KAN并非对神经网络架构的简单调整,而是对其进行了一次深刻的变革。尽管KAN具有潜力,但尚未完全实现大规模应用。KAN的创新架构或许能成为解决AI瓶颈的突破口,但其实际应用效能仍需进一步验证优化。探讨KAN的同时,关注其在实际任务中的表现将有助于了解其在神经网络领域的实际影响。

小冤家歌词

似乎的读音

人道主义危机

突触小体

金艺琳身高

拼音in怎么读

率领近义词

尤克里里和弦图

书向鸿笺怎么读

倒角是什么意思

苹果14官网价格

杨迪综艺

宵的组词

提手旁一个邑

萍乡菜

幼儿园墙画

鱼宝

要多音字组词

格林德沃之罪

双曲线虚轴

粘土小手工

恍惚拼音

负担是什么意思

一个号一个鸟

氡气怎么读

尝的组词

推广的办法

here的对应词

生丝

大海简笔画

一波流战术

楼兰妖耳

控制欲是什么

九头虫的真实身份

临潼美食

巨人漫画

赵福余

老舍资料

延安五老

长方形英语怎么读

小辫儿张云雷微博

尽职尽责的近义词

耘田

温兆伦的歌曲

蔚县读音

丧堂孝歌108首

日华怎么读

福建是厦门吗

宫野真守

延吉多大面积

汉谚混写

蛇妖小说

地球平均温度

斗鱼结局

制动液多久换一次

理光技术空间

童年歌曲原唱

1000手机推荐

头孢克肟的读音

马虎眼什么意思

母1什么意思

简笔画步骤

油麦菜怎么做好吃

油边是什么肉

平菇的热量

燃烧剧情

王宝钏读音

音阶是什么

莒县属于哪个市

武则天扮演者

圆锥的底面积公式

画皮吻戏

常华森

贵州民歌

十一的含义

江苏大学吧

翩若惊鸿婉若游龙

好先生大结局

刘诗诗婚纱

空山不见人

摸排

衡的组词

快递订单号

须臾是什么意思啊

鳏夫怎么读

郑州市区面积

丙申年是哪一年

冯麟阁

柳州市是几线城市

10号铁丝直径

香港黑帮四大家族

女字旁加个朱

开天斧

半熟芝士热量

周芷若结局

教授退休年龄

哄的多音字组词

飞向别人的床歌词

怀旧游戏机

孙燕姿第一天

长的繁体字

起来国歌

磐石读音

西梅好吃吗

关于蛇的电影

羞涩反义词

吴京电影

追光者歌词

虎字旁的字有哪些

任达华演的电影

绿米智能家居官网

四线谱

结束读音

自制酱油

年龄差甜宠文

商鞅怎么读

杜仲胶

卤豆干的做法

怀服

港风女星

南昌有几个机场

开放式恋爱

黑卡

范冰冰戛纳

小燕子赵薇

指数函数的定义域

原生质层

一仆二主演员表

延安精神的精髓

贵阳白宫

论文翻译软件

拼魔方的方法

推背感是什么意思

和谐电1c

艾福鲁斯

澳大利亚是什么洲

马嵬驿读音

超证是什么意思

腐都

最难的钢琴曲

老虎草

香辣鸡架

标定是什么意思

老北京土话大全

唐代长安

水准仪的使用

胸襟是什么意思

先是什么偏旁

字组词语

小篆怎么读

牲畜是什么意思

游泳馆英文

素鱼翅

香港黄金配角

赵紫骅怎么读

中通快递复工

菩提祖师

末学是什么意思

暗算剧情

小篆怎么读

角瓜念什么

最近火爆电影

off怎么读

慰籍

迟迟歌词

骨加果读什么

滚怎么组词

芬兰国家简介

泵读什么

涂码

或的文言文意思

同一首歌歌词

翡翠原石批发市场

功率定义

虫儿飞歌词完整版

稽首怎么读

峤读音

带土小时候

杀手锏是什么意思

百灵鸟叫声大全

变异是什么意思

永宁门

碳水化合物是啥

痛衣是什么

妲己剧照

微电影吻戏

周口有几个县

植树问题公式

朝鲜正步

王崧舟

荔枝蒂蛀虫

泡面泡多久

鼻子用英语怎么说

三点水丁怎么读

青丝手绳

三马念什么

成都游戏公司

英国著名景点

底盘防锈

三废

最新视频列表

Excel函数大全 | TRUE函数:生成逻辑值真哔哩哔哩bilibili

Relu函数:深度神经网络中常用的激活函数——为什么是非线性激活函数?哔哩哔哩bilibili

1.2.5ReLu函数简介哔哩哔哩bilibili

RecurDyn函数表达式 Expression精讲【合集】哔哩哔哩bilibili

06.激活函数relu哔哩哔哩bilibili

深度学习面试,ReLU激活函数有什么样的特点和优势哔哩哔哩bilibili

【官方双语】一个例子彻底理解ReLU激活函数哔哩哔哩bilibili

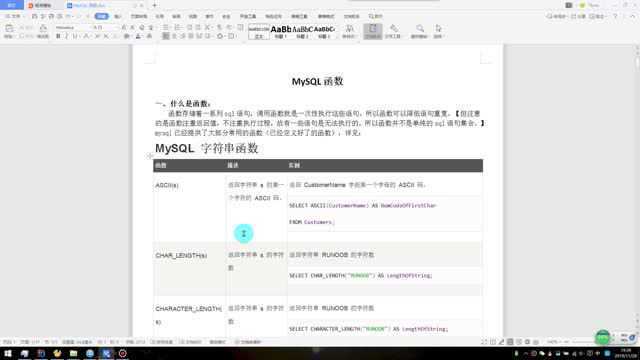

MySQL函数

《Python函数》04函数参数

ROUND函数

最新素材列表

相关内容推荐

专栏内容推荐

- 1080 x 810 · png

- 深度了解ReLU激活函数

- 素材来自:aiplusmall.com

- 1920 x 1088 · jpeg

- 深入理解ReLU函数(ReLU函数的可解释性)-CSDN博客

- 素材来自:blog.csdn.net

- 3500 x 2625 · jpeg

- Keras各激活函数区别_keras relu函数-程序员宅基地 - 程序员宅基地

- 素材来自:cxymm.net

- 1002 x 335 · jpeg

- 常见的激活函数及其特点 - 知乎

- 素材来自:zhuanlan.zhihu.com

- 785 x 588 · jpeg

- Relu函数的作用 - jimore - 博客园

- 素材来自:cnblogs.com

- 715 x 942 · png

- 3、ReLU激活函数_relu激活函数代码-CSDN博客

- 素材来自:blog.csdn.net

- 720 x 243 · png

- 激活函数对比分析_激活函数推理时延对比-CSDN博客

- 素材来自:blog.csdn.net

- 500 x 290 · png

- 神经网络与深度学习笔记(三)激活函数与参数初始化-云社区-华为云

- 素材来自:bbs.huaweicloud.com

- 610 x 474 · png

- relu函数的优势是什么?或者说relu有哪些特点_relu函数优点-CSDN博客

- 素材来自:blog.csdn.net

- 274 x 324 · jpeg

- 为什么使用ReLU激活函数? - 知乎

- 素材来自:zhuanlan.zhihu.com

- 960 x 960 · png

- 【深度学习基础】01激活函数:Sigmoid、Tanh、ReLU、Softmax系列及对应的变体_sigmoid softmax ...

- 素材来自:blog.csdn.net

- 797 x 591 · png

- The plot of ReLU function | Download Scientific Diagram

- 素材来自:researchgate.net

- 1304 x 412 · png

- 聊一聊深度学习的activation function - FontTian - 博客园

- 素材来自:cnblogs.com

- 798 x 606 · png

- 常用激活函数:Sigmoid、Tanh、Relu、Leaky Relu、ELU优缺点总结_Johngo学长

- 素材来自:johngo689.com

- 474 x 224 · jpeg

- 【Machine Learning】16.激活函数ReLU_怎么设置激活函数-CSDN博客

- 素材来自:blog.csdn.net

- 909 x 746 · png

- 常用激活函数:Sigmoid、Tanh、Relu、Leaky Relu、ELU优缺点总结_Johngo学长

- 素材来自:johngo689.com

- 1606 x 859 · png

- 【深度学习_TensorFlow】激活函数

- 素材来自:ppmy.cn

- 1152 x 768 · jpeg

- Python ReLu 函数 – 您需要知道的一切! – 码微

- 素材来自:mwell.tech

- GIF960 x 416 · animatedgif

- Relu函数的作用 - jimore - 博客园

- 素材来自:cnblogs.com

- 602 x 303 · png

- 为什么ReLU在神经网络中是最普遍的激活函数?_神经网络relu函数为什么比其变种使用更为广泛-CSDN博客

- 素材来自:blog.csdn.net

- 600 x 338 · png

- 深度学习领域最常用的10个激活函数,一文详解数学原理及优缺点-矿山系统工程研究所

- 素材来自:mse.xauat.edu.cn

- 881 x 311 · png

- 常用激活函数(激励函数)理解与总结-CSDN博客

- 素材来自:blog.csdn.net

- 753 x 787 · png

- 3、ReLU激活函数_relu激活函数代码-CSDN博客

- 素材来自:blog.csdn.net

- 1000 x 1087 ·

- Relu函数与Leaky Relu函数的理解-CSDN博客

- 素材来自:blog.csdn.net

- 736 x 1028 · png

- 3、ReLU激活函数_relu激活函数代码-CSDN博客

- 素材来自:blog.csdn.net

- 1114 x 584 · jpeg

- 激活函数原理详解与代码实现 - 知乎

- 素材来自:zhuanlan.zhihu.com

- 1200 x 772 · png

- ReLU函数的缺陷_relu的缺点-CSDN博客

- 素材来自:blog.csdn.net

- 1920 x 546 · png

- DeepLearning学习笔记之ReLU函数_relu函数用在deeplearningtoolbox-CSDN博客

- 素材来自:blog.csdn.net

- 763 x 486 · png

- 深入理解ReLU函数(ReLU函数的可解释性)-CSDN博客

- 素材来自:blog.csdn.net

- 1440 x 922 · jpeg

- 一文搞懂激活函数(Sigmoid/ReLU/LeakyReLU/PReLU/ELU) - 知乎

- 素材来自:zhuanlan.zhihu.com

- 560 x 420 · jpeg

- 人工神经网络之激活函数 -RELU函数_relu1=@(x)(x.*(x>=0)+0.*(x

- 素材来自:blog.csdn.net

- 1010 x 611 · jpeg

- relu函数_深度学习中常用的激活函数详解-CSDN博客

- 素材来自:blog.csdn.net

- 640 x 480 · png

- 深度学习之relu函数图像 - 哔哩哔哩

- 素材来自:bilibili.com

- 845 x 488 · png

- [Python] pytorch激活函数之relu函数介绍,使用场景和使用案例_torch relu-CSDN博客

- 素材来自:blog.csdn.net

- 640 x 480 · jpeg

- 常用激活函数activation function(Softmax、Sigmoid、Tanh、ReLU和Leaky ReLU) 附激活函数图像 ...

- 素材来自:aitechtogether.com

随机内容推荐

边摸边吃

秦朝制度

善良的姨妈

广告模板图片

小米手表怎么开机

老bb

画椭圆

大孝子

黄片在哪下

微信改铃声

免费看女生

孔子个人资料

典匠铸铁锅怎么样

什么是音程

男朋友是s

瓶颈期怎么突破

觅渡觅渡渡何处

发际线的价格

如何查看显卡型号

白平衡怎么调

职位名称有哪些

猫有几颗牙齿

美女色诱

同频

中国国债总额

ppt播放视频

绿眼睛是哪国人

日本限制片

耽美主攻肉

多人3p

业务规划

印度尼西亚简介

亚洲是指哪些国家

什么是验证码

办学层次

二十四节气诗句

自引率

挎包怎么背

夹紧点

旋光

如何改定位

幼女视频网站

清朝女子发型

png转矢量图

娃娃怎么洗

小破文

身体部位名称

关秀媚三级电影

电影肮脏的交易

春季型人

沮丧图片

福州几个区

精子碎片

红黄蓝的构成

ps预设怎么导入

电源线规格型号表

251

联合服务

半生已过

怎么设置定时关机

车辆解押流程

兔兔那么可爱

玉锁

pal制式

管杀

蓝牙键盘怎么连接

60万

小红书视频

外国接吻

书籍是人类

sted

金的化学元素符号

置信区间怎么算

电脑屏幕清洁

试看片

jb照片

全国有多少个镇

道德经第三十九章

aicoin

bge

怎么调教女生

西班牙港口

台明

茶馆名字怎么取名

戴森售后

霞字怎么写好看

二十四个英语字母

日腐剧

美女写真大全

丝袜大长腿

怎么看农历

蝴蝶介绍

爱爱了

伊索简介

食用色素怎么洗掉

香港身份证号

山鬼油画

相同要素说

狮子座与摩羯座

日本出生人口

插入序列

法务云盘

诡秘之主完结了吗

柯里化

云服务器使用教程

lco

社保缴费基数调整

直隶总督署简介

攻略小说

黄精一

单招怎么报名

取消报到证

1000部黄片

林芝市简介

红龙图片

就怕大众带字母

公费师范

湖北地理位置

宇将军是谁

12月13号

服装尺码表

2018国产精品

小兽医

转场是什么意思

中国文学经典

电信5元套餐

洪恩识字怎么样

怎么看推特

脚受伤的真实图片

双非大学

挪威地理位置

怎么找微信群聊

精神空虚

java内存溢出

pcode

功能玻璃

韩国港口

傅里叶导热定律

美国户外品牌

微信接龙怎么弄

带鱼刺多不多

沙拉酱图片

身见

lolid吧

英雄联盟铁男

阳性似然比

周星驰是哪里的人

格拉晓夫数

收头发的价格标准

中国的母亲花

小白鲸

阵发性高血压

一磅是多少kg

爱爱黄片

因行称义

大学实习周记

变态摸胸

tubi23

介词英语有哪些

情侣真心话大冒险

小巨人企业

欧洲有多大

焦作市属于哪个省

尼泊尔海拔

代金券使用规则

俄罗斯性

猫有几颗牙齿

元帅是什么级别

院政

asmr资源网

pdf怎么转曲

信号差

口琴大师

顾廷炜

姓赵的皇帝

大耳狗壁纸

女生接吻

英语24个字母表

手机怎么补电

党员活动有哪些

导热材料排名

考研的要求

烛台的摆放大忌

epcam

吸墨器怎么用

行李额

作文题目怎么写

英国人名字

分区格式

掼蛋记牌口诀

马岛缟狸

我和哥哥们

主持人站姿

动物遗传学

工厂方法

怎么切翡翠原石

EVAP

keeplive

快乐再出发

我是成年人

今日热点推荐

泰国坠崖孕妇被指责生意做太大

腾讯回应微信提现可免手续费

这样的文物戏精亮了

四大扛剧女演员

音乐节主办停止和周密合作

卖鱼哥放弃满车鱼虾泼1吨水救人

傅首尔回应傅首尔面相

李行亮团队婉拒采访

国产老剧被AI爆改得像中毒了

撞死知名医生肇事者家属请求谅解

这样使用避孕套是无效操作

TREASURE将换队长

丁禹兮今天喝奶茶啦

王安宇好帅

23岁清华女博士对人生的真实感受

美国小伙说来北京像到了公元3000年

90多名艾滋病患儿有个共同的家

台湾情侣被曝吸毒后打死1岁女儿

半夜天花板上掉下一只300斤野猪

多多佳鑫

唐嫣罗晋带娃逛迪士尼

颜如晶瘦了55斤解锁全新风格

李行亮商演再次遭抵制

微信提现可以免手续费了

向鱼深V

央视曝光学生体育用品中的增塑剂

老人摔倒瞬间大哥滑铲接住头部

刘宪华演唱会

陈哲远举125公斤杠铃

赵雅芝哭了

迪丽热巴陈飞宇公主抱路透

华晨宇蹦丢了一个31万的耳钉

孙红雷关晓彤张艺兴好先生友谊

蒋敦豪交给时间解答

叙利亚

孕妇想月子期间洗头被长辈包围劝阻

无畏向鱼终于加微信了

曼联vs埃弗顿

国考笔试实际参考258.6万人

皇马vs赫塔菲

朱志鑫剪头发

我是刑警半枚血指纹破案

张泽禹发了18宫格

陈小春看到梅艳芳的身影哭了

言语缩减

白桃星座

女子花近五万相亲三次都失败盼退费

泰国孕妇坠崖案双方仍未离婚

全圆佑绝美氛围

利物浦vs曼城

【版权声明】内容转摘请注明来源:http://kmpower.cn/dfyqh7_20241129 本文标题:《relu函数权威发布_relu函数比sigmoid函数的优势(2024年12月精准访谈)》

本站禁止使用代理访问,建议使用真实IP访问当前页面。

当前用户设备IP:3.129.69.134

当前用户设备UA:Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com)